==================================================

!warning!

본 게시글은 본인의 학습기록을 위해 작성된 알려진 학습 기법

함부로 악의적으로 이용은 엄연히 불법 임으로

절대 시도하지 말 것이며

사고 발생 시 본인은 절대로 책임지지 않습니다!

==================================================

Chapter 05. 정보 수집

기본 설치 파일을 통한 시스템 정보 수집

스샷. 1

– php로 개발된 경우 phpinfo.php라는 기본 설치 파일을 통해 환경 정보,

환경 변수 등 관련 정보를 얻을 수 있습니다.

웹 취약점 스캐닝

스샷. 2

-nikto를 통해 웹 스캐닝 실행한 모습

디렉터리 인덱싱(디렉터리 리스팅)

-인덱싱이 발견된 디렉토리로 접근 가능성이 있다고 나온다고 합니다.

스샷. 3

-웹 서버의 잘못된 설정으로 웹 서버 디렉터리의 파일들이

비엔나소시지 마냥 줄줄이 노출됩니다.(…)

스샷. 4

-백업 파일을 통해서도 중요한 정보를 찾을 수 있습니다.(!!!)

웹 어플리케이션 매핑

스샷. 5

– 버프 스위트 인터셉트 끄고, 사이트 프록시 키고 웹 애플리케이션 이것저것

클릭하고

돌아다니면 위 스샷. 5처럼 매핑해줍니다.

2 . 크롤링

– 크롤러를 이용하면 웹 애플리케이션 매핑

과정을 자동으로 수행할 수 있습니다.

– 매핑된 거 오른쪽 마우스 클릭해서 스파이더 실행시키면 됨,

보통 수동으로 매핑하고 스파이더(자동 매핑) 하는 것이

정확합니다.

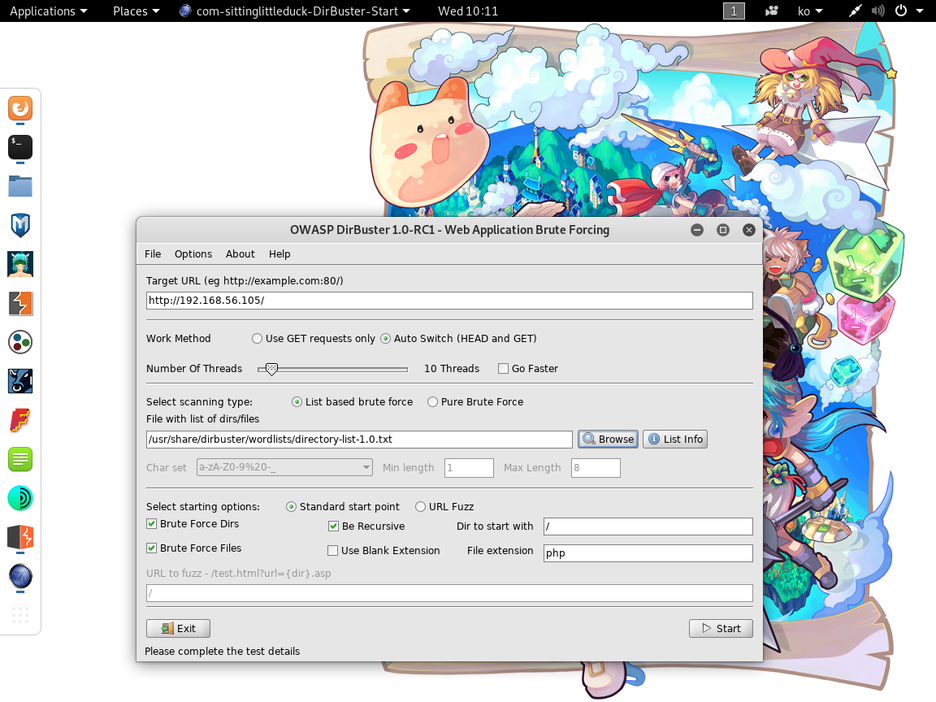

3 . DisBuster

– URL 목록 파일을 사용하여 각 URL을 자동으로 입력해보는 방식으로 웹

애플리케이션 구조 파악합니다.(목록 파일을 사용하여 정보를

찾는 기법을 브루트 포스 공격이라도 함)

– 스파이더는 숨겨진 페이즈를 못 찾는데 얘는 찾아줍니다.

(~~심영 : 여기 이쪽에.. 찾으란 말이오–~~)

(~~의사 양반 : 내.. 내 용사님~~)

– 명령어는 dirbuster 을 실행해줍니다.

스샷. 6

– 타깃 URL 지정하고, [Browse] 눌러서

사용할 리스트 선택해줘야 합니다.

(/usr/share/dirbuster/wordlists)

스샷. 7

스샷. 8

– dirbuster로 찾은 url을 직접 접속해 보면서 수종

매핑과크롤링을 추가로 연계할 수 있습니다.

(resutls에서 결과 볼 수 있음)

4 . robots.txt

– 웹사이트 운영자 및 개발자는 robot를 최상위 디렉터리에

위치시켜 웹 로봇에게 해당 웹사이트의

정보 수집을 허용하거나 불허한다는 명령을 내릴 수 있습니다.

스샷. 9

– 해당 스샷은 goodbotd에게는 사이트 정보 수집을 허용하지나

badbot에게는 허용하지 않겠다는 뜻입니다.

(User-agent를 사용해 모든 웹 봇에게 알릴 수 있는데

밑에 수집하지 말라고 기재해놓은 디렉터리에서

힌트를 얻을 수도 있습니다.)

웹 어플리케이션 매핑1 . 불필요한 정보 삭제

– 웹 방화벽과 같은 장비를 이용하여 헤더를 일괄적으로 삭제하거나,

웹 프레임워크의 자체적인 기능을 활용

2 . 스캐너/크롤러 차단

스샷. 10

– 위 스샷. 10 같은 명령어를 작성하면 아파치 웹 서버 접근 로그에

기록된 요청 헤더 정보와 횟수 등을 확인할 수 있습니다.

3 . 디렉터리 인덱싱 설정 제거

– 디럭터리 인덱싱의 경우 웹 서버의 설정을 변경하여 대응.

아파치의 경우는 etc/apache2/apache2.conf 파일의

indexex 옵션을 제거합니다.

————————————————–

오늘 챕터 5 작성 완료… 휴…글 쓰는 것도 쉬운 일이 아니군요 ㅋㅅㅋ;;

아무튼 긴 글을 읽어 주셔서 감사하고

좋은 하루 보내시고, 하시는 일 잘 되시고

코로나 조심 하시길 바랍니다.

'모의해킹 > 화이트해커 를 위한 웹 해킹의 기술' 카테고리의 다른 글

| Chapter07. SQL 인젝션 공격 (0) | 2022.02.26 |

|---|---|

| Chapter 06 취약한 인증 공격 (0) | 2022.02.26 |

| Chapter 04. 버프 스위트 (0) | 2022.02.26 |

| Chapter 02. 웹 보안 (0) | 2022.02.26 |

| Chapter 01. 웹과 HTTP 기초 (0) | 2022.02.26 |

모의해킹/화이트해커 를 위한 웹 해킹의 기술